Quando la Tecnologia ti Conosce Meglio di Quanto tu Conosca te Stesso

Come e’ possibile che a capo del 99% delle popolazioni del pianeta vi siano Leader che obbediscono ad un unico Dictact come quello della globalizzazione ed il neoliberismo selvaggio che sta distruggendo il pianeta?

Semplice, perché la maggioranza della gente li ha votati…

e come ha potuto accadere tutto questo?

Perché chi ti conosce bene fa di te tutto quello che vuole.

E allora?

Conosci te stesso e nessuno potrai mai incidere indiscriminatamente sulle tue scelte

Toba60

La Tecnologia sa tutto di te e tu conosci te stesso ?

Lo storico Yuval Noah Harari e l’etico Tristan Harris discutono il futuro dell’intelligenza artificiale con il direttore di WIRED Nicholas Thompson.

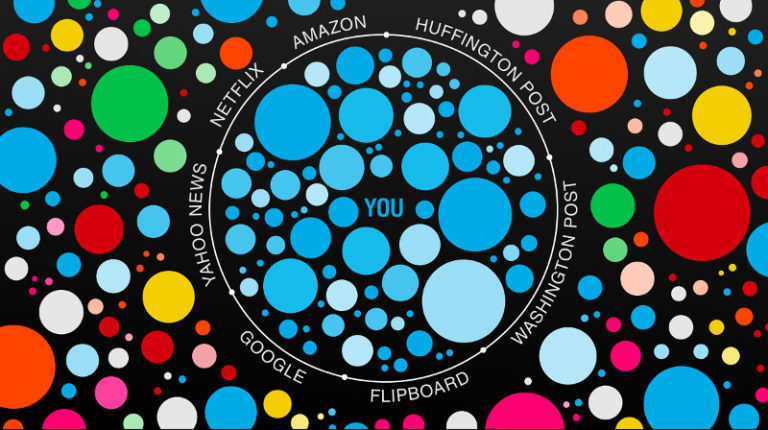

Forse il fatto più importante del vivere nel 21° secolo è che ora siamo animali hackerabili.

Quando hai 2 anni, tua madre sa più cose su di te di quante ne sappia tu stesso. Man mano che cresci, cominci a capire cose della tua mente che nemmeno lei conosce. Ma poi, dice Yuval Noah Harari, un altro concorrente si unisce alla corsa: “Hai questa corporazione o governo che ti corre dietro, e sono ben oltre tua madre, e sono alle tue spalle”. Amazon saprà presto quando hai bisogno di lampadine prima che si brucino.

YouTube sa come tenerti a fissare lo schermo molto più a lungo di quando è nel tuo interesse smettere. Un inserzionista in futuro potrebbe conoscere le tue preferenze sessuali prima che ti siano chiare. (E certamente le conoscerà prima che tu l’abbia detto a tua madre).

Ho avuto la possibilità di parlare con Harari, l’autore di tre libri best-seller, e Tristan Harris, che gestisce il Center for Humane Technology e che ha avuto un ruolo sostanziale nel rendere il “tempo ben speso” forse la frase più discussa nella Silicon Valley nel 2018.

Sono due delle persone più intelligenti nel mondo della tecnologia, e ognuno ha parlato in modo eloquente della conoscenza di sé e di come gli esseri umani possono rendersi più difficili da hackerare. Come ha detto Harari, “Ora stiamo affrontando non solo una crisi tecnologica ma una crisi filosofica”.

Per favore, leggete o guardate tutto. Questa trascrizione è stata modificata per chiarezza.

Nicholas Thompson: Tristan, dimmi un po’ cosa fai e poi Yuval, dimmelo anche tu.

Tristan Harris: Sono direttore del Center for Humane Technology, dove ci concentriamo sul riallineamento della tecnologia con un modello di natura umana dagli occhi chiari. E prima ero un etico del design a Google, dove ho studiato l’etica della persuasione umana.

Yuval Noah Harari: Sono uno storico e cerco di capire da dove viene l’umanità e dove siamo diretti.

NT: Cominciamo a sentire come vi siete incontrati, perché so che risale a un po’ di tempo fa. Quando vi siete conosciuti?

YNH: Curiosamente, durante una spedizione in Antartide, siamo stati invitati dal governo cileno al Congresso del Futuro per parlare del futuro dell’umanità e una parte del Congresso era una spedizione alla base cilena in Antartide per vedere con i nostri occhi il riscaldamento globale. Faceva ancora molto freddo e c’erano così tante persone interessanti in questa spedizione

TH: Molti filosofi e premi Nobel. E penso che abbiamo legato particolarmente con Michael Sandel, che è un filosofo di filosofia morale davvero straordinario.

NT: È quasi come un reality show. Mi sarebbe piaciuto vedere il tutto. Scrivete di cose diverse, parlate di cose diverse ma ci sono molte somiglianze. E uno dei temi chiave è l’idea che le nostre menti non funzionano come a volte pensiamo. Non abbiamo così tanto potere sulle nostre menti come forse abbiamo creduto fino ad ora. Tristan, perché non cominci a parlare di questo e poi interviene Yuval, e partiamo da lì.

TH: Sì, in realtà ho imparato molto di questo da uno dei primi discorsi di Yuval, dove parla della democrazia come “Dove dovremmo mettere l’autorità in una società? E dove dovremmo metterla nelle opinioni e nei sentimenti delle persone.

Ma tutto il mio background: In realtà ho passato gli ultimi 10 anni a studiare la persuasione, a partire da quando ero un mago da bambino, dove si impara che ci sono cose che funzionano su tutte le menti umane. Non importa se hanno un dottorato di ricerca, se sono un fisico nucleare, che età hanno. Non è come, Oh, se parli giapponese non posso fare questo trucco su di te, non funzionerà.

Funziona su tutti. Quindi in qualche modo c’è questa disciplina che riguarda gli exploit universali su tutte le menti umane. E poi sono stato al Persuasive Technology Lab di Stanford che insegna agli studenti di ingegneria come applicare i principi della persuasione alla tecnologia.

La tecnologia potrebbe essere in grado di hackerare i sentimenti umani, gli atteggiamenti, le credenze, i comportamenti per mantenere le persone impegnate con i prodotti? E penso che la cosa che entrambi condividiamo è che la mente umana non è l’enclave totale e sicura di autorità che pensiamo che sia, e se vogliamo trattarla in questo modo dobbiamo prima capire cosa deve essere protetto.

YNH: Penso che ora stiamo affrontando davvero, non solo una crisi tecnologica, ma una crisi filosofica. Perché abbiamo costruito la nostra società, certamente la democrazia liberale con le elezioni e il libero mercato e così via, su idee filosofiche del XVIII secolo che sono semplicemente incompatibili non solo con le scoperte scientifiche del XXI secolo, ma soprattutto con la tecnologia che abbiamo ora a disposizione.

La nostra società è costruita sull’idea che l’elettore sa meglio, che il cliente ha sempre ragione, che l’autorità ultima è, come ha detto Tristan, è con i sentimenti degli esseri umani e questo presuppone che i sentimenti umani e le scelte umane sono queste arene sacre che non possono essere violate, che non possono essere manipolate.

In definitiva, le mie scelte, i miei desideri riflettono il mio libero arbitrio e nessuno può accedervi o toccarlo. E questo non è mai stato vero. Ma non abbiamo pagato un costo molto alto per credere in questo mito nel XIX e XX secolo perché nessuno aveva una tecnologia per farlo davvero. Ora, le persone alcune persone – le corporazioni, i governi stanno giocando la tecnologia per hackerare gli esseri umani. Forse il fatto più importante del vivere nel 21° secolo è che ora siamo animali hackerabili.

Hackerare un umano

NT: Spiega cosa significa hackerare un essere umano e perché quello che si può fare ora è diverso da quello che si poteva fare 100 anni fa.

YNH: Hackerare un essere umano è capire cosa succede dentro di te a livello del corpo, del cervello, della mente, in modo da poter prevedere cosa faranno le persone. Puoi capire come si sentono e puoi, naturalmente, una volta che capisci e prevedi, di solito puoi anche manipolare e controllare e persino sostituire.

E naturalmente non si può fare perfettamente, ed era possibile farlo in una certa misura anche un secolo fa. Ma la differenza di livello è significativa. Direi che la vera chiave è se qualcuno può capirti meglio di quanto tu capisca te stesso.

Gli algoritmi che stanno cercando di violarci non saranno mai perfetti. Non esiste la possibilità di capire perfettamente tutto o di prevedere tutto. Non è necessario essere perfetti, basta essere meglio dell’essere umano medio.

NT: E siamo arrivati a questo punto? O sei preoccupato che ci stiamo per arrivare?

YNH: Penso che Tristan potrebbe essere in grado di rispondere a dove siamo ora meglio di me, ma credo che se non siamo lì ora, ci stiamo avvicinando molto molto velocemente.

TH: Penso che un buon esempio di questo sia YouTube. Apri quel video di YouTube che il tuo amico ti manda dopo la pausa pranzo. Torni al tuo computer e pensi OK, so che le altre volte finisco per guardare due o tre video e finisco per essere risucchiato, ma questa volta sarà davvero diverso. Guarderò solo questo video e poi, in qualche modo, non è quello che succede.

Ti svegli dalla trance tre ore dopo e dici: “Che diavolo è successo? Ed è perché non ti sei reso conto di avere un supercomputer puntato sul tuo cervello. Così quando apri quel video stai attivando i miliardi di dollari di potenza di calcolo di Google, che hanno esaminato ciò che ha mai portato 2 miliardi di animali umani a cliccare su un altro video.

E sa molto di più su quale sarà la mossa di scacchi perfetta da giocare contro la tua mente. Se pensi alla tua mente come a una scacchiera, e pensi di conoscere la mossa perfetta da giocare – guarderò solo questo video. Ma tu puoi vedere solo tante mosse avanti sulla scacchiera. Ma il computer vede la tua mente e dice: “No, no, no.

Ho già giocato un miliardo di simulazioni di questa partita di scacchi su questi altri animali umani che guardano YouTube”, e vincerà. Pensate a quando Garry Kasparov perde contro Deep Blue. Garry Kasparov può vedere tante mosse avanti sulla scacchiera. Ma non può vedere oltre un certo punto, come un topo può vedere tante mosse avanti in un labirinto, ma un umano può vedere molte più mosse avanti e allora Garry può vedere ancora più mosse avanti.

Ma quando Garry perde contro IBM Deep Blue, è scacco matto contro l’umanità per tutti i tempi perché era il miglior giocatore di scacchi umano. Quindi non è che stiamo perdendo completamente il potere umano e tu entri su YouTube e ti coinvolge per il resto della tua vita e non lasci mai lo schermo. Ma ovunque ti giri su internet c’è fondamentalmente un supercomputer che punta al tuo cervello, giocando a scacchi contro la tua mente, e vincerà molto più spesso che non.

‘Ovunque accendi Internet c’è fondamentalmente un supercomputer che punta al tuo cervello, che gioca a scacchi contro la tua mente, e vincerà il più delle volte.’

Tristan Harris

NT: Parliamo di questa metafora perché gli scacchi sono un gioco con un vincitore e un perdente. Questo particolare video spero sia chiarificatore e illuminante.

Quindi gli scacchi sono davvero la metafora giusta? Un gioco con un vincitore e un perdente.

TH: Beh, la domanda è: qual è veramente il gioco che si sta giocando? Quindi se il gioco che si sta giocando fosse: Ehi Nick, vai a meditare in una stanza per due ore e poi torna da me e dimmi cosa vuoi veramente adesso nella tua vita.

E se YouTube sta usando 2 miliardi di animali umani per calcolare in base a tutti quelli che hanno mai voluto imparare a suonare l’ukulele può dire: “Ecco il video perfetto che ho da insegnare dopo che può essere grande”. Il problema è che in realtà non si preoccupa di ciò che vuoi, si preoccupa solo di ciò che ti terrà vicino allo schermo.

La cosa che funziona meglio per mantenere più a lungo una ragazza adolescente che guarda un video di diete su YouTube è dire: ecco un video di anoressia. Se mandi in onda una persona su un video sulla notizia dell’11 settembre, solo un video di notizie basate sui fatti, il video che suona dopo è quello di Alex Jones InfoWars.

NT: Quindi cosa succede a questa conversazione?

TH: Sì, credo che dipenderà molto! L’altro problema è che si può anche, in un certo senso, hackerare queste cose, e quindi ci sono governi che possono effettivamente manipolare il modo in cui funziona il sistema di raccomandazione. E così Yuval ha detto che questi sistemi sono un po’ fuori controllo e gli algoritmi stanno tipo gestendo dove 2 miliardi di persone passano il loro tempo.

Il settanta per cento di ciò che la gente guarda su YouTube è guidato dalle raccomandazioni dell’algoritmo. La gente pensa che ciò che si guarda su YouTube sia una scelta. La gente è seduta lì, si siede lì, pensa e poi sceglie. Ma questo non è vero.

Il settanta per cento di ciò che la gente guarda sono i video raccomandati sul lato destro, il che significa il 70 per cento di 1,9 miliardi di utenti, che è più del numero di seguaci dell’Islam, circa il numero di seguaci del cristianesimo, di ciò che stanno guardando su YouTube per 60 minuti al giorno – questo è il tempo medio che la gente passa su YouTube.

Quindi hai 60 minuti, e il 70% è popolato da un computer. La macchina è fuori controllo. Perché se pensavate che le teorie della cospirazione dell’11 settembre fossero brutte in inglese, provate le cospirazioni dell’11 settembre in birmano e Sri Lanka e in arabo. È una specie di Frankenstein digitale che tira tutte queste leve e guida la gente in tutte queste diverse direzioni.

NT: E, Yuval, siamo arrivati a questo punto dicendo che questo ti spaventa per la democrazia. E ti fa preoccupare se la democrazia può sopravvivere, o credo che la frase che usi nel tuo libro sia: La democrazia diventerà uno spettacolo di marionette. Spieghi questo.

YNH: Sì, voglio dire, se non si adatta a queste nuove realtà, diventerà solo uno spettacolo di marionette emotive. Se si continua con questa illusione che la scelta umana non può essere violata, non può essere manipolata, e possiamo fidarci completamente, e questa è la fonte di tutta l’autorità, allora molto presto si finisce con uno spettacolo di marionette emotive.

E questo è uno dei più grandi pericoli che stiamo affrontando ed è davvero il risultato di una sorta di impoverimento filosofico di dare per scontate le idee filosofiche del XVIII secolo e non aggiornarle con le scoperte della scienza. Ed è molto difficile perché si va dalle persone – le persone non vogliono sentire questo messaggio che sono animali violabili, che le loro scelte, i loro desideri, la loro comprensione di chi sono io, quali sono le mie aspirazioni più autentiche, queste possono effettivamente essere violate e manipolate.

Per dirla in breve, la mia amigdala potrebbe lavorare per Putin. Non voglio saperlo. Non voglio crederci. No, sono un agente libero. Se ho paura di qualcosa, questo è a causa mia. Non perché qualcuno ha piantato questa paura nella mia mente. Se scelgo qualcosa, questo è il mio libero arbitrio, e chi sei tu per dirmi qualcos’altro?

NT: Beh, spero che Putin lavorerà presto per la mia amigdala, ma questo è un progetto secondario che ho in corso. Ma sembra inevitabile, da quello che hai scritto nel tuo primo libro, che avremmo raggiunto questo punto, dove le menti umane sarebbero state hackerabili e dove i computer e le macchine e l’IA avrebbero capito meglio di noi.

Ma non è certo inevitabile che questo ci porti a risultati negativi, alle teorie della cospirazione dell’11 settembre e a una democrazia distrutta. Quindi abbiamo raggiunto il punto di non ritorno? Come possiamo evitare il punto di non ritorno se non ci siamo ancora arrivati? E quali sono i punti di decisione chiave lungo la strada?

YNH: Beh, niente è inevitabile in questo. Voglio dire che la tecnologia stessa si svilupperà. Non si può fermare tutta la ricerca nell’IA e non si può fermare tutta la ricerca nelle biotecnologie.

E le due cose vanno insieme. Penso che l’IA riceva troppa attenzione ora, e dovremmo mettere la stessa enfasi su ciò che sta accadendo sul fronte delle biotecnologie, perché per hackerare gli esseri umani, hai bisogno della biologia e alcuni degli strumenti e delle intuizioni più importanti, non vengono dall’informatica, ma dalla scienza del cervello. E molte delle persone che progettano tutti questi incredibili algoritmi, hanno un background in psicologia e scienza del cervello, perché questo è ciò che si sta cercando di hackerare.

Ma di cosa dovremmo renderci conto? Possiamo usare la tecnologia in molti modi diversi. Voglio dire, per esempio, ora stiamo usando l’IA principalmente per sorvegliare gli individui al servizio delle corporazioni e dei governi.

Ma può essere capovolto nella direzione opposta. Possiamo usare gli stessi sistemi di sorveglianza per controllare il governo al servizio degli individui, per monitorare, per esempio, i funzionari governativi che non siano corrotti.

La tecnologia è disposta a farlo. La questione è se siamo disposti a sviluppare gli strumenti necessari per farlo.

“Per dirla in breve, la mia amigdala potrebbe lavorare per Putin”.

Yuval Noah Harari

TH: Penso che uno dei punti principali di Yuval sia che la biotecnologia ti permette di capire, collegando un sensore a qualcuno, caratteristiche di quella persona che non conoscerà su se stessa, e stanno sempre più facendo il reverse-engineering dell’animale umano. Una delle cose interessanti che ho seguito è anche il modo in cui si possono accertare quei segnali senza un sensore invasivo.

E stavamo parlando di questo un secondo fa. C’è qualcosa chiamato ingrandimento video euleriano in cui si punta una telecamera del computer sul volto di una persona. Poi se metto un supercomputer dietro la telecamera, posso effettivamente eseguire un’equazione matematica, e posso trovare i microimpulsi di sangue al tuo viso che io come umano non posso vedere ma che il computer può vedere, così posso cogliere la tua frequenza cardiaca.

Cosa mi permette di fare? Posso rilevare il tuo livello di stress perché la variabilità della frequenza cardiaca mi dà il tuo livello di stress. Posso indicare c’è una donna di nome Poppy Crum che ha fatto un discorso TED quest’anno sulla fine della faccia da poker, che abbiamo avuto questa idea che ci può essere una faccia da poker, possiamo effettivamente nascondere le nostre emozioni alle altre persone.

Ma questo discorso riguarda l’erosione di ciò, che possiamo puntare una telecamera sui tuoi occhi e vedere quando i tuoi occhi si dilatano, che in realtà rileva le tensioni cognitive quando hai difficoltà a capire qualcosa o quando è facile capire qualcosa.

Possiamo continuamente regolare questo in base alla frequenza cardiaca e alla dilatazione degli occhi. Sapete, una delle cose con Cambridge Analytica è l’idea – sapete, che è tutto sull’hacking della Brexit e della Russia e di tutte le altre elezioni americane – che era basata su, se conosco i vostri cinque grandi tratti di personalità, se conosco la personalità di Nick Thompson attraverso la sua apertura, coscienziosità, estroversione, gradevolezza e nevroticità, questo mi dà la vostra personalità.

E sulla base della vostra personalità, posso sintonizzare un messaggio politico per essere perfetto per voi. Ora l’intero scandalo è stato che Facebook ha lasciato andare questi dati per essere rubati da un ricercatore che faceva compilare alle persone dei questionari per capire quali sono i cinque grandi tratti della personalità di Nick? Ma ora c’è una donna di nome Gloria Mark alla UC Irvine che ha fatto una ricerca che dimostra che si possono effettivamente ottenere i cinque grandi tratti della personalità delle persone solo dai loro modelli di clic, con una precisione dell’80%. Quindi di nuovo, la fine della faccia da poker, la fine delle parti nascoste della tua personalità.

Saremo in grado di puntare le IA sugli animali umani e capire sempre più segnali da loro, comprese le loro micro espressioni, quando si sorride e tutte queste cose, abbiamo telecamere Face ID su tutti questi telefoni. Così ora se hai un ciclo stretto in cui posso adattare i messaggi politici in tempo reale alla tua frequenza cardiaca e alla dilatazione degli occhi e alla tua personalità politica. Non è un mondo in cui si vuole vivere. È una specie di distopia.

YNH: In molti contesti, puoi usarlo. Può essere usato in classe per capire se uno degli studenti non sta capendo il messaggio, se lo studente è annoiato, il che potrebbe essere una cosa molto buona. Può essere usato dagli avvocati, come quando si negozia un accordo e se io posso leggere cosa c’è dietro la tua faccia da poker, e tu no, questo è un enorme vantaggio per me.

Così può essere fatto in un contesto diplomatico, come due primi ministri che si incontrano per risolvere il conflitto israelo-palestinese, e uno di loro ha una cimice nell’orecchio e un computer gli sta sussurrando all’orecchio qual è il vero stato emotivo. Cosa sta succedendo nel cervello della persona dall’altra parte del tavolo.

E cosa succede quando le due parti hanno questo? E si ha una specie di corsa agli armamenti. E non abbiamo assolutamente idea di come gestire queste cose. Ho fatto un esempio personale quando ne ho parlato a Davos. Così ho parlato del mio intero approccio a questi problemi, plasmato dalla mia esperienza di coming out.

Ho capito di essere gay quando avevo 21 anni, e da allora sono stato perseguitato da questo pensiero. Cosa ho fatto nei cinque o sei anni precedenti? Voglio dire, come è possibile? Non sto parlando di qualcosa di piccolo che non sai di te stesso – tutti hanno qualcosa che non sai di te stesso.

Ma come è possibile che tu non sappia questo di te stesso? E poi il pensiero successivo è che un computer e un algoritmo avrebbero potuto dirmelo così facilmente quando avevo 14 anni con qualcosa di semplice come seguire la messa a fuoco dei miei occhi. Tipo, non so, cammino sulla spiaggia o guardo la televisione, e c’è – cos’era negli anni ’80, Baywatch o qualcosa del genere – e c’è un ragazzo in costume da bagno e c’è una ragazza in costume da bagno e da che parte vanno i miei occhi.

È così semplice. E poi penso, come sarebbe stata la mia vita, in primo luogo, se avessi saputo quando avevo 14 anni? Secondo, se avessi avuto queste informazioni da un algoritmo? Voglio dire, se c’è qualcosa di incredibilmente, come dire, sgonfiante per l’ego, che questa è la fonte di questa saggezza su me stesso, un algoritmo che ha seguito i miei movimenti?

Coca Cola contro Pepsi

NT: E c’è un elemento ancora più inquietante, di cui lei scrive nel suo libro: E se la Coca-Cola l’avesse capito per prima e ti stesse vendendo Coca-Cola con uomini a torso nudo, quando tu non sapevi nemmeno di essere gay?

YNH: Giusto, esattamente! Coca-Cola contro Pepsi: La Coca-Cola sa questo di me e mi mostra uno spot con un uomo a torso nudo; la Pepsi non sa questo di me perché non usa questi sofisticati algoritmi. Vanno con le normali pubblicità con la ragazza in bikini. E naturalmente compro la Coca-Cola, e non so nemmeno perché. La mattina dopo, quando vado al supermercato, compro la Coca-Cola, e penso che questa sia la mia libera scelta. Ho scelto la Coca-Cola. Ma no, sono stato hackerato.

NT: E quindi questo è inevitabile.

TH: Questo è l’intero problema. Questo è tutto ciò di cui stiamo parlando. E come ti fidi di qualcosa che può estrarre questi segnali da te? Se un sistema è asimmetrico – se tu sai di me più di quanto io sappia di me stesso, di solito abbiamo un nome per questo nella legge. Così, per esempio, quando hai a che fare con un avvocato, consegni i tuoi dettagli molto personali ad un avvocato in modo che ti possa aiutare.

Ma poi loro hanno questa conoscenza della legge e sanno delle tue informazioni vulnerabili, quindi potrebbero sfruttarti con questo. Immagina un avvocato che prende tutte quelle informazioni personali e le vende a qualcun altro. Ma sono governati da una relazione diversa, che è la relazione fiduciaria.

Possono perdere la loro licenza se non servono davvero i vostri interessi. E allo stesso modo un medico o uno psicoterapeuta. Anche loro ce l’hanno. Quindi c’è questa grande questione di come possiamo consegnare informazioni su di noi e dire: “Voglio che tu le usi per aiutarmi”. Quindi, con quale autorità posso garantire che mi aiuterai?

YNH: Con l’avvocato, c’è questa impostazione formale. OK, ti assumo come mio avvocato, questa è la mia informazione. E noi lo sappiamo. Ma sto camminando per strada e c’è una telecamera che mi guarda. Non so nemmeno che sta succedendo.

TH: Questa è la parte più duplice. Se vuoi sapere cos’è Facebook, immagina un prete in una cabina di confessione, e loro ascoltano le confessioni di 2 miliardi di persone. Ma ti guardano anche tutto il giorno, cosa clicchi, quali pubblicità di Coca-Cola o Pepsi, o l’uomo senza maglietta e le donne senza maglietta, e tutte le tue conversazioni che hai con chiunque altro nella tua vita – perché hanno Facebook Messenger, hanno anche quei dati – ma immagina che questo prete in una cabina di confessione, il loro intero modello di business, sia vendere l’accesso alla cabina di confessione ad un’altra parte.

Così qualcun altro può manipolarvi. Perché è l’unico modo in cui questo prete fa soldi in questo caso. Quindi non fanno soldi in nessun altro modo.

NT: Ci sono grandi aziende che avranno questi dati, lei ha menzionato Facebook, e ci saranno i governi. Di cosa si preoccupa di più?

YNH: È lo stesso. Cioè, una volta che si arriva oltre un certo punto, non importa come lo si chiama. Questa è l’entità che effettivamente governa, chiunque abbia questo tipo di dati. Voglio dire, anche se in un contesto in cui si ha ancora un governo formale, e questi dati sono nelle mani di qualche società, allora la società se vuole può decidere chi vince le prossime elezioni.

Quindi non c’è molta scelta. Voglio dire che c’è una scelta. Possiamo progettare un sistema politico ed economico diverso per impedire questa immensa concentrazione di dati e di potere nelle mani dei governi o delle corporazioni che li usano senza essere responsabili e senza essere trasparenti su ciò che fanno. Il messaggio non va bene. È finita. L’umanità è nella pattumiera della storia.

NT: Non è questo il messaggio.

YNH: No, non è questo il messaggio.

NT: Phew. Gli occhi hanno smesso di dilatarsi, continuiamo.

YNH: La vera questione è che dobbiamo far capire alla gente che questo è reale. Questo sta accadendo. Ci sono cose che possiamo fare. E come, sapete, avete le elezioni di metà mandato in un paio di mesi. Così in ogni dibattito, ogni volta che un candidato va ad incontrare i potenziali elettori, di persona o in televisione, fate loro questa domanda: Qual è il vostro piano? Qual è la vostra posizione su questo problema? Cosa farà se la eleggeremo? Se dicono “Non so di cosa stai parlando”, questo è un grosso problema.

TH: Penso che il problema sia che la maggior parte di loro non ha idea di cosa stiamo parlando. E questo è uno dei problemi: penso che i politici, come abbiamo visto, non siano molto istruiti su questi temi.

NT: Stanno facendo meglio. Stanno facendo molto meglio quest’anno rispetto all’anno scorso. Guardando le audizioni al Senato, le ultime audizioni con Jack Dorsey e Sheryl Sandberg, rispetto alle audizioni di Zuckerberg o alle audizioni di Colin Stretch, c’è stato un miglioramento.

TH: È vero. C’è molto di più, però. Penso che questi temi aprano un intero spazio di possibilità. Non sappiamo ancora che tipo di cose saremo in grado di prevedere. Come abbiamo menzionato alcuni esempi di cui siamo a conoscenza.

Ma se hai un modo segreto di sapere qualcosa su una persona puntando una telecamera su di essa e AI, perché dovresti pubblicarlo? Quindi ci sono un sacco di cose che possono essere conosciute su di noi per manipolarci in questo momento e di cui non siamo nemmeno a conoscenza.

E come iniziamo a regolare tutto ciò? Penso che la relazione che vogliamo governare sia quando un supercomputer è puntato su di te, quella relazione deve essere protetta e governata da una serie di leggi.

Utente, Proteggi te stesso

NT: E così ci sono tre elementi in questa relazione. C’è il supercomputer: Cosa fa? Cosa non fa? C’è la dinamica di come è puntato. Quali sono le regole su ciò che può raccogliere, quali sono le regole per ciò che non può raccogliere e ciò che può memorizzare? E ci siete voi. Come ti alleni ad agire? Come vi allenate ad avere consapevolezza di voi stessi? Quindi parliamo di tutte e tre queste aree forse iniziando dalla persona. Cosa dovrebbe fare la persona in futuro per sopravvivere meglio in questa dinamica?

TH: Una cosa che vorrei dire a questo proposito è che penso che l’autoconsapevolezza sia importante. È importante che la gente conosca la cosa di cui stiamo parlando e che si renda conto che possiamo essere violati. Ma non è una soluzione. Hai milioni di anni di evoluzione che guidano la tua mente a fare certi giudizi e conclusioni.

Un buon esempio di questo è se indosso un casco VR, e ora improvvisamente mi trovo in uno spazio dove c’è una sporgenza, sono sul bordo di un precipizio, so consapevolmente che sono seduto qui in una stanza con Yuval e Nick, lo so consapevolmente. Quindi ho lasciato che l’autoconsapevolezza – so di essere manipolato. Ma se mi spingi, non voglio cadere, giusto? Perché ho milioni di anni di evoluzione che mi dicono che mi stai spingendo da un cornicione.

Così, allo stesso modo, si può dire che -an Ariely fa questa battuta in realtà, un economista comportamentale- che l’adulazione funziona su di noi anche se ti dico che me la sto inventando. È come dire: Nick, mi piace la tua giacca in questo momento. Sento che ti sta benissimo. E’ una giacca davvero fantastica.

NT: In realtà l’ho scelto perché sapevo, studiando la tua espirazione di anidride carbonica ieri…

TH: Esattamente, ora ci stiamo manipolando a vicenda…

Il punto è che anche se sai che me lo sto solo inventando, è comunque una bella sensazione. L’adulazione è una bella sensazione. E così è importante pensare a questo come a una nuova era, una sorta di nuova illuminazione in cui dobbiamo vedere noi stessi in un modo molto diverso e questo non significa che sia l’intera risposta. È solo il primo passo che dobbiamo fare.

NT: Quindi il primo passo è riconoscere che siamo tutti vulnerabili, hackerabili.

TH: Giusto, vulnerabili.

NT: Ma ci sono differenze. Yuval è meno hackerabile di me perché medita due ore al giorno e non usa lo smartphone. Io sono super hackerabile. Quindi quali sono le altre cose che un umano può fare per essere meno hackerabile?

YNH: Quindi devi conoscere te stesso il meglio possibile. Non è una soluzione perfetta, ma se qualcuno ti corre dietro, tu corri più veloce che puoi. Voglio dire che è una competizione. Quindi chi ti conosce meglio nel mondo? Così quando hai 2 anni è tua madre. Alla fine speri di raggiungere una fase della vita in cui ti conosci ancora meglio di tua madre. E poi improvvisamente, hai questa corporazione o governo che ti corre dietro, e sono ben oltre tua madre, e sono alle tue spalle.

Stanno per arrivare a te – questo è il momento critico. Ti conoscono meglio di quanto tu conosca te stesso. Quindi corri via, corri un po’ più veloce. E ci sono molti modi in cui puoi correre più veloce, cioè conoscerti un po’ meglio. Quindi la meditazione è un modo.

E ci sono centinaia di tecniche di meditazione, modi diversi che funzionano con persone diverse. Puoi andare in terapia, puoi usare l’arte, puoi usare lo sport, qualsiasi cosa. Qualunque cosa funzioni per te.

Ma ora sta diventando molto più importante che mai. Sai che è il consiglio più vecchio del libro: Conosci te stesso. Ma in passato non c’era competizione. Se tu vivessi nell’antica Atene e arrivasse Socrate e ti dicesse: “Conosci te stesso. È un bene, ti fa bene”. E tu hai detto: “No, sono troppo occupato. Ho questo uliveto di cui mi devo occupare, non ho tempo”.

Quindi ok, non hai conosciuto meglio te stesso, ma non c’era nessun altro che era in competizione con te. Ora hai una concorrenza seria. Quindi hai bisogno di conoscere meglio te stesso. Ma questa è la prima massima. In secondo luogo come individuo, se parliamo di quello che sta succedendo alla società, dovresti renderti conto che non puoi fare molto da solo. Unisciti a un’organizzazione.

Ad esempio, se sei davvero preoccupato per questo, questa settimana unisciti a qualche organizzazione. Cinquanta persone che lavorano insieme sono una forza molto più potente di 50 individui, che ognuno di loro è un attivista. È bene essere un attivista.

È molto meglio essere membro di un’organizzazione. E poi ci sono altri metodi collaudati e provati di fare politica. Dobbiamo tornare a questa cosa disordinata di fare regolamenti e scelte politiche di tutto questo. È forse la più importante. La politica riguarda il potere. Ed è qui che si trova il potere in questo momento.

“Il sistema in sé può fare cose incredibili per noi. Abbiamo solo bisogno di girarlo, che serva i nostri interessi, qualunque essi siano e non gli interessi della corporazione o del governo”.

Yuval Noah Harari

TH: Aggiungo a questo. Penso che ci sia la tentazione di dire OK, come possiamo proteggerci? E quando questa conversazione si sposta sul fatto che il mio smartphone non mi sta hackerando, si ottengono cose come: Oh, imposterò il mio telefono in scala di grigi. Oh, spegnerò le notifiche. Ma ciò che manca è che si vive all’interno di un tessuto sociale.

Camminiamo fuori. La mia vita dipende dalla qualità dei pensieri, delle credenze e delle vite delle altre persone. Quindi, se tutti intorno a me credono in una teoria della cospirazione perché YouTube sta prendendo 1,9 miliardi di animali umani e inclinando il campo di gioco in modo che tutti guardino Infowars – a proposito, YouTube ha guidato 15 miliardi di raccomandazioni di Alex Jones InfoWars, e questa è una raccomandazione. E poi 2 miliardi di visualizzazioni – se solo una persona su mille crede a quei 2 miliardi di visualizzazioni, sono comunque 2 milioni di persone.

YNH: La matematica non è il nostro forte.

TH: E quindi se sono 2 milioni di persone, sono ancora 2 milioni di nuovi teorici della cospirazione. Se tu dici ehi io sono un ragazzo, sono un adolescente e non voglio preoccuparmi del numero di like che ottengo, quindi smetterò di usare Snapchat o Instagram. Non voglio essere violato dalla mia autostima in termini di like.

Posso dire che non voglio usare quelle cose ma vivo ancora in un tessuto sociale dove tutte le mie altre opportunità sessuali, opportunità sociali, trasmissione dei compiti, dove la gente parla di quella roba, se usano solo Instagram, devo partecipare a quel tessuto sociale. Quindi penso che dobbiamo elevare la conversazione da, Come mi assicuro di non essere violato.

Non è solo una conversazione individuale. Vogliamo che la società non sia violata, che va al punto politico e a come ci mobilitiamo politicamente come gruppo per cambiare l’intera industria. Voglio dire, per me, penso all’industria tecnologica.

NT: Quindi questo è un po’ il primo passo di questa domanda in tre fasi. Cosa possono fare gli individui? Conoscere se stessi, rendere la società più resiliente, rendere la società meno capace di essere violata. E la trasmissione tra il supercomputer e l’uomo? Quali sono le regole e come dovremmo pensare a come limitare la capacità del supercomputer di hackerarti?

YNH: Questa è una grande domanda.

TH: È una grande domanda.

NT: È il motivo per cui siamo qui!

YNH: In sostanza, penso che dobbiamo accettare il fatto che non possiamo impedirlo completamente. E non è a causa dell’IA, è a causa della biologia. È solo il tipo di animali che siamo, e il tipo di conoscenza che ora abbiamo sul corpo umano, sul cervello umano.

Abbiamo raggiunto un punto in cui questo è davvero inevitabile. E non c’è nemmeno bisogno di un sensore biometrico, si può semplicemente usare una telecamera per dire qual è la mia pressione sanguigna. Cosa sta succedendo ora, e attraverso questo, cosa mi sta succedendo emotivamente.

Quindi direi che abbiamo bisogno di riconcettualizzare completamente il nostro mondo. Ed è per questo che ho iniziato dicendo che soffriamo di impoverimento filosofico, che stiamo ancora correndo sulle idee del 18° secolo, che sono buone per due o tre secoli, che erano molto buone, ma che semplicemente non sono adeguate per capire quello che sta succedendo ora. Ed è per questo che penso anche che, sai, con tutti i discorsi sul mercato del lavoro e su cosa dovrebbero studiare oggi che sarà rilevante per il mercato del lavoro tra 20-30 anni, penso che la filosofia sia forse una delle migliori scommesse.

NT: A volte scherzo sul fatto che mia moglie ha studiato filosofia e danza al college, che all’epoca sembravano le due peggiori professioni perché non si può davvero trovare lavoro in nessuna delle due. Ma ora sono le ultime due cose che verranno sostituite dai robot.

TH: Penso che Yuval abbia ragione. Penso che, spesso, questa conversazione faccia concludere alle persone che non c’è nulla nelle scelte umane o nei sentimenti della mente umana che valga la pena rispettare. E non credo che questo sia il punto.

Penso che il punto sia che abbiamo bisogno di un nuovo tipo di filosofia che riconosca un certo tipo di pensiero o processo cognitivo o processo concettuale o processo sociale che vogliamo. Come per esempio [James] Fishkin è un professore di Stanford che ha fatto un lavoro sulla democrazia deliberativa e ha dimostrato che se metti un campione casuale di persone in una stanza d’albergo per due giorni e hai degli esperti che entrano e li informano su una serie di cose, cambiano la loro mente sulle questioni, passano da essere polarizzati a meno polarizzati, possono arrivare a un maggiore accordo.

E c’è una sorta di processo lì che si può mettere in un cestino e dire, questo è un processo cognitivo sociale di creazione di senso che potremmo voler campionare da quello, al contrario di un individuo solitario alienato a cui sono state mostrate foto dei loro amici che si divertono senza di loro tutto il giorno, e poi li stiamo colpendo con annunci russi.

Probabilmente non vogliamo campionare un segnale da quella persona – non che non vogliamo da quella persona, ma non vogliamo che quel processo sia la base di come prendiamo decisioni collettive.

Quindi penso, sapete, che siamo ancora bloccati in una mescola mente-corpo, non ne usciamo, quindi è meglio imparare come usarla in modo da far emergere gli angeli più alti della nostra natura, le parti più riflessive di noi stessi.

Quindi penso che ciò che i progettisti di tecnologia devono fare è porre questa domanda. Quindi un buon esempio, solo per renderlo pratico, prendiamo di nuovo YouTube. Qual è la differenza tra un adolescente – prendiamo l’esempio di: Guardate il video dell’ukulele. È una cosa molto comune su YouTube.

Ci sono molti video di ukulele, come suonare l’ukulele. Cosa succede in quel momento quando raccomanda altri video di ukulele? Beh, in realtà c’è un valore di qualcuno che vuole imparare a suonare l’ukulele, ma il computer non lo sa, sta solo raccomandando altri video di ukulele. Ma se lo sapesse davvero, invece di dire solo, ecco altri infiniti video di ukulele da guardare, potrebbe dire ed ecco i tuoi 10 amici che sanno suonare l’ukulele che non sapevi sapessero suonare l’ukulele e puoi uscire con loro. In pratica potrebbe mettere queste scelte in cima al menu della vita.

YNH: Il sistema in sé può fare cose incredibili per noi. Abbiamo solo bisogno di girarlo, che serva i nostri interessi, qualunque essi siano e non gli interessi della corporazione o del governo. OK, ora che abbiamo capito che il nostro cervello può essere violato, abbiamo bisogno di un antivirus per il cervello, proprio come ne abbiamo uno per il computer.

E può funzionare sulla base della stessa tecnologia. Diciamo che hai un assistente AI che ti controlla tutto il tempo, 24 ore al giorno. Cosa scrivi? Cosa vedi? Tutto. Ma questa IA è al tuo servizio come una responsabilità fiduciaria. E arriva a conoscere le tue debolezze, e conoscendo le tue debolezze può proteggerti da altri agenti che cercano di hackerarti e di sfruttare le tue debolezze.

Così, se hai un debole per i video di gatti divertenti e passi un’enorme quantità di tempo, una quantità smodata di tempo, a guardare – sai che non ti fa molto bene, ma non riesci proprio a smettere di cliccare, allora l’IA interverrà, e ogni volta che questi video di gatti divertenti cercheranno di comparire, l’IA dirà no no no no.

E vi mostrerà semplicemente un messaggio che qualcuno ha appena cercato di violarvi. Proprio come si ricevono questi messaggi su qualcuno che ha appena cercato di infettare il tuo computer con un virus e può finire.

Voglio dire, la cosa più difficile per noi è ammettere le nostre debolezze e i nostri pregiudizi, e può andare in tutti i modi. Se avete un pregiudizio contro Trump o contro i sostenitori di Trump, allora credereste molto facilmente a qualsiasi storia, per quanto inverosimile e ridicola.

Quindi, non so, Trump pensa che il mondo sia piatto. Trump è a favore dell’uccisione di tutti i musulmani. Voi ci clicchereste sopra. Questo è il vostro pregiudizio. E l’IA lo saprà, ed è completamente neutrale, non serve nessuna entità là fuori. Impara solo a conoscere le tue debolezze e i tuoi pregiudizi e cerca di proteggerti da essi.

NT: Ma come fa ad imparare che si tratta di una debolezza e di un pregiudizio? E non qualcosa che ti piace veramente?

TH: È qui che penso che abbiamo bisogno di un quadro filosofico più ricco. Perché se ce l’hai, allora puoi rendere quella comprensione. Quindi se un adolescente è seduto lì e in quel momento sta guardando il video della dieta e poi gli viene mostrato il video dell’anoressia.

Immaginate che invece di un ingegnere maschio di 22 anni che è andato a Stanford, uno scienziato informatico, pensi: “Cosa posso mostrare loro che sia la cosa perfetta? Avete uno psicologo dello sviluppo infantile di 80 anni che ha studiato sotto i migliori psicologi dello sviluppo infantile e ha pensato che in quel tipo di momenti la cosa che di solito è in corso per un adolescente all’età di 13 anni è una sensazione di insicurezza, lo sviluppo dell’identità, come la sperimentazione.

Cosa sarebbe meglio per loro? Quindi pensiamo a questo è come l’intera struttura della tecnologia umana è pensiamo che questa sia la cosa: dobbiamo tenere lo specchio a noi stessi per capire le nostre vulnerabilità prima. E si progetta partendo da una visione di ciò a cui siamo vulnerabili. Penso che da un punto di vista pratico sono totalmente d’accordo con questa idea di una AI sidekick, ma se stiamo immaginando di vivere nella realtà, la spaventosa realtà di cui stiamo parlando ora.

Non è come se questo fosse un futuro fantascientifico. Questo è lo stato attuale. Quindi stiamo pensando a come navigare verso un reale stato di cose che vogliamo, probabilmente non vogliamo che un assistente AI sia questa sorta di cosa opzionale che alcune persone ricche possono permettersi e altre no, probabilmente vogliamo che sia incorporato nel modo in cui la tecnologia funziona in primo luogo, in modo che abbia una responsabilità fiduciaria nei nostri migliori, sottili, compassionevoli, vulnerabili interessi.

NT: Quindi avremo aiutanti AI sponsorizzati dal governo? Avremo corporazioni che ci vendono aiutanti di IA ma li sovvenzionano, così non saranno solo i ricchi ad avere aiutanti di IA veramente buoni?

TH: È qui che entra in gioco la conversazione sul modello di business.

YNH: Una cosa è cambiare il modo in cui – se vai all’università o al college e impari l’informatica, allora una parte integrante del corso è imparare l’etica, l’etica del coding. Ed è davvero, penso che sia estremamente irresponsabile, che tu non possa finire, puoi avere una laurea in informatica e in codifica e puoi progettare tutti questi algoritmi che ora modellano la vita delle persone, e semplicemente non hai alcun background nel pensare eticamente e filosoficamente a ciò che stai facendo. Stavi solo pensando in termini di pura tecnicità o in termini economici. E così questa è una cosa che fa parte della torta fin dall’inizio.

NT: Ora lascia che ti chieda una cosa che è venuta fuori un paio di volte e che mi sono chiesto. Quando hai fatto l’esempio dell’ukulele, hai parlato del fatto che forse dovresti andare a trovare degli amici che suonano l’ukulele, dovresti andare a trovarli offline.

E nel tuo libro dici che uno dei momenti cruciali per Facebook arriverà quando un ingegnere si renderà conto che la cosa migliore per la persona e per la comunità è che lasci il suo computer. E poi cosa farà Facebook con questo? Quindi sembra, da una prospettiva morale, che una piattaforma, se si rende conto che sarebbe meglio per te andare offline e vedere qualcuno, dovrebbe incoraggiarti a farlo. Ma poi, perderanno i loro soldi e saranno superati dalla concorrenza. Quindi come si arriva al punto in cui l’algoritmo, la piattaforma spinge qualcuno in quella direzione?

TH: Quindi è qui che questa conversazione sul modello di business è così importante e anche perché il ruolo di Apple e Google è così importante perché sono prima del modello di business di tutte queste applicazioni che vogliono rubare il tuo tempo e massimizzare l’attenzione.

Quindi Android e iOS, non per rendere questa conversazione troppo tecnica o incentrata sull’industria, ma dovrebbero teoricamente – quel livello, hai solo il dispositivo, chi dovrebbe servire? Il miglior interesse di chi stanno servendo? Vogliono che le applicazioni abbiano il maggior successo possibile? E rendere il tempo, sapete, la dipendenza, massimizzando, sapete, la solitudine, l’alienazione e il confronto sociale e tutta quella roba? O quello strato dovrebbe essere un fiduciario come assistente dell’IA ai nostri interessi più profondi, alle nostre vite fisiche incarnate, alle nostre comunità fisiche incarnate.

Come se non potessimo sfuggire a questo strumento, e si scopre che essere all’interno della comunità e avere un contatto faccia a faccia è, sapete, c’è una ragione per cui l’isolamento è la peggiore punizione che diamo agli esseri umani. E abbiamo una tecnologia che sta fondamentalmente massimizzando l’isolamento perché ha bisogno di massimizzare il tempo in cui stiamo sullo schermo.

Quindi penso che una domanda sia come possono Apple e Google spostare le loro intere attività per essere sulla responsabilità fiduciaria locale incarnata verso la società. E quello che noi pensiamo come tecnologia umana, che è la direzione in cui possono andare.

Facebook potrebbe anche cambiare il suo modello di business per essere più sui pagamenti e le persone che effettuano transazioni basate sullo scambio di cose, che è qualcosa che stanno esaminando con la blockchain su cui stanno teoricamente lavorando e anche i pagamenti di messenger.

Se si spostano da un modello di business basato sulla pubblicità ai micropagamenti, potrebbero effettivamente spostare il design di alcune di queste cose. E ci potrebbero essere interi team di ingegneri a News Feed che stanno solo pensando a ciò che è meglio per la società e poi la gente continuerebbe a fare queste domande, beh, chi è Facebook per dire cosa è bene per la società? Ma non si può uscire da questa situazione perché essi modellano ciò che 2 miliardi di animali umani pensano e sentono ogni giorno.

NT: Quindi questo mi porta ad una delle cose su cui voglio sentire i tuoi pensieri, che è Apple e Google hanno entrambi fatto questo in una certa misura nell’ultimo anno. E anche Facebook. Credo che ogni dirigente di ogni azienda tecnologica abbia detto “tempo ben speso” ad un certo punto nell’ultimo anno.

Abbiamo avuto un’enorme conversazione su questo e la gente ha comprato 26 trilioni di questi libri. Pensi davvero che stiamo andando nella giusta direzione in questo momento perché il cambiamento sta avvenendo e la gente sta pensando? O pensa che stiamo ancora andando nella direzione sbagliata?

YNH: Penso che nel mondo della tecnologia stiamo andando nella giusta direzione nel senso che la gente si sta rendendo conto della posta in gioco. Le persone si stanno rendendo conto dell’immenso potere che hanno nelle loro mani – sto parlando di persone nel mondo tecnologico – si stanno rendendo conto dell’influenza che hanno sulla politica, sulla società, e così via. E la maggior parte di loro reagisce, penso, non nel miglior modo possibile, ma certamente nel modo responsabile di capire, sì, abbiamo questo enorme impatto sul mondo.

Non l’abbiamo pianificato forse. Ma sta succedendo e dobbiamo pensare molto attentamente a cosa fare con questo. Non sanno cosa farne. Nessuno lo sa veramente, ma almeno il primo passo è stato compiuto, di rendersi conto di ciò che sta accadendo e prendersi qualche responsabilità.

Il luogo dove vediamo uno sviluppo molto negativo è a livello globale, perché tutti i discorsi finora sono stati davvero una sorta di discorsi interni alla Silicon Valley, California, USA. Ma le cose stanno accadendo in altri paesi. Voglio dire che tutti i discorsi che abbiamo fatto finora si basavano su quello che sta succedendo nelle democrazie liberali e nei liberi mercati. In alcuni paesi, forse non hai alcuna scelta.

Devi solo condividere tutte le tue informazioni e devi solo fare quello che l’algoritmo sponsorizzato dal governo ti dice di fare. Quindi è una conversazione completamente diversa e poi un altro tipo di complicazione è la corsa agli armamenti dell’IA che cinque anni fa, o anche due anni fa, non esisteva.

E ora è forse la priorità numero uno in molti luoghi del mondo che c’è una corsa agli armamenti in corso nell’IA, e noi, il nostro paese, abbiamo bisogno di vincere questa corsa agli armamenti. E quando si entra in una situazione di corsa agli armamenti, allora diventa molto rapidamente una corsa al ribasso, perché molto spesso si sente dire: “Ok, è una cattiva idea fare questo, sviluppare quello, ma loro lo stanno facendo e questo dà loro qualche vantaggio e noi non possiamo rimanere indietro. Noi siamo i buoni.

Non vogliamo farlo, ma non possiamo permettere ai cattivi di essere davanti a noi, quindi dobbiamo farlo per primi. E se chiedete alle altre persone, vi diranno la stessa cosa. E questo è uno sviluppo estremamente pericoloso.

TH: È un dilemma del prigioniero. È una trappola multipolare. Voglio dire che ogni attore nessuno vuole costruire droni bot da macello. Ma se penso che tu possa farlo, anche se non voglio, devo costruire e tu costruisci. E li teniamo entrambi.

NT: E anche ad un livello più profondo, se vuoi costruire un po’ di etica nei tuoi droni robot da macello, ma questo ti rallenterà.

TH: Giusto. E una delle sfide una delle cose di cui abbiamo parlato quando ci siamo incontrati per la prima volta è stata l’etica della velocità, della frequenza di clock.

Perché il più veloce – siamo in sostanza in competizione su chi può andare più veloce per fare questa roba, ma più veloce significa più probabilità di essere pericoloso, meno probabilità di essere sicuro.

Quindi è fondamentalmente stiamo correndo il più velocemente possibile per creare le cose che probabilmente dovremmo creare il più lentamente possibile. E penso che, proprio come il trading ad alta frequenza nei mercati finanziari, non vuoi che la gente faccia saltare in aria intere montagne per poter posare questi cavi di rame in modo da poter commerciare un microsecondo più velocemente.

Quindi non sei nemmeno in competizione sulla base di una versione di Adam Smith di ciò che apprezziamo o qualcosa del genere. Si compete fondamentalmente su chi può far saltare in aria le montagne e fare transazioni più velocemente.

Quando aggiungi il trading ad alta frequenza a chi può programmare gli esseri umani più velocemente e chi è più efficace nel manipolare le guerre culturali in tutto il mondo, questo diventa come una corsa al fondo del tronco cerebrale del caos totale.

Quindi penso che dobbiamo dire come possiamo rallentare questo e creare un ritmo ragionevole, e penso che questo riguardi anche una tecnologia umana, invece di uno psicologo dello sviluppo infantile, chiedete a qualcuno, come voi sapete lo psicologo, quali sono i tassi di clock del processo decisionale umano in cui tendiamo effettivamente a fare buone scelte ponderate? Probabilmente non volete che un’intera società sia spinta a, sapete, fare 100 scelte all’ora su qualcosa di veramente importante.

Quindi qual è la giusta frequenza di clock? Penso che dobbiamo fare in modo che la tecnologia ci guidi verso questo tipo di processi decisionali.

Il problema sta migliorando o peggiorando?

NT: Quindi torniamo alla domanda originale. Sei in qualche modo ottimista su alcune delle piccole cose che stanno accadendo in questo luogo molto piccolo? Ma profondamente pessimista sulla completa cancellazione dell’umanità?

TH: Penso che il punto di Yuval sia giusto che, sai, c’è una domanda sulle aziende tecnologiche americane, che sono più grandi di molti governi – Facebook controlla i pensieri di 2,2 miliardi di persone. Mark Zuckerberg è l’editore capo dei pensieri di 2,2 miliardi di persone. Ma poi ci sono anche, sapete, i governi mondiali o, scusate, i governi nazionali che sono governati da un diverso insieme di regole. Penso che le aziende tecnologiche si stiano svegliando molto, molto lentamente. E finora, sapete, con la roba del Time Well Spent, per esempio, è aiutare le persone, perché sono vulnerabili a quanto tempo spendono, a impostare un limite su quanto tempo spendono.

Ma questo non affronta nessuno di questi problemi più grandi su come si possono programmare i pensieri di una democrazia, come la salute mentale e l’alienazione possono essere dilaganti tra gli adolescenti, portando al raddoppio dei tassi di suicidio adolescenziale per le ragazze negli ultimi otto anni. Quindi sapete che dovremo avere una visione molto più completa e una ristrutturazione dell’industria tecnologica per pensare a ciò che è bene per le persone.

E ci sarà una transizione scomoda, ho usato questa metafora, è come con il cambiamento climatico. Ci sono alcuni momenti nella storia in cui un’economia è sostenuta da qualcosa che non vogliamo. Quindi il più grande esempio di questo è la schiavitù nel 1800. C’era un punto in cui la schiavitù sosteneva l’intera economia mondiale. Non si poteva semplicemente dire: “Non vogliamo più fare questo, succhiiamolo fuori dall’economia”. L’intera economia crollerebbe se lo facessi. Ma l’impero britannico, quando decise di abolire la schiavitù, dovette rinunciare al 2% del suo PIL ogni anno per 60 anni e fu in grado di fare quella transizione in un periodo di transizione, e quindi non sto equiparando la pubblicità o la programmazione degli esseri umani alla schiavitù.

Non lo sto facendo. Ma c’è una struttura simile dell’intera economia ora, se guardate il mercato azionario, come un’enorme fetta del valore, è guidata da questi sistemi basati sulla programmazione pubblicitaria-umana-animale. Se volessimo risucchiare quel modello, il modello pubblicitario, in realtà non possiamo permetterci quella transizione. Ma ci potrebbero essere anni imbarazzanti in cui si è fondamentalmente in quel lungo percorso di transizione.

Penso che in questo momento dobbiamo farlo molto più velocemente di quanto abbiamo fatto in altre situazioni perché le minacce sono più urgenti.

NT: Yuval, sei d’accordo che questa è una delle cose a cui dobbiamo pensare quando pensiamo di cercare di aggiustare il sistema mondiale nei prossimi decenni?

YNH: È una delle cose. Ma di nuovo, il problema del mondo, dell’umanità, non è solo il modello pubblicitario. Voglio dire che gli strumenti di base sono stati progettati c’erano le persone più brillanti del mondo, 10 o 20 anni fa, che risolvevano questo problema di, Come faccio a far cliccare la gente sulla pubblicità? Alcune delle persone più intelligenti di sempre, questo era il loro lavoro, risolvere questo problema.

E l’hanno risolto. E poi i metodi che hanno usato inizialmente per venderci biancheria intima e occhiali da sole e vacanze ai Caraibi e cose del genere, sono stati dirottati e trasformati in armi, e ora sono usati per venderci ogni genere di cose, comprese opinioni politiche e intere ideologie. E ora non è più sotto il controllo del gigante tecnologico della Silicon Valley che ha aperto la strada a questi metodi. Questi metodi sono là fuori. Quindi, anche se riesci a convincere Google e Facebook a rinunciarvi completamente, il gatto è fuori dal sacco.

La gente sa già come farlo. E c’è una corsa agli armamenti in questa arena. Quindi sì, dobbiamo capire questo business della pubblicità. È molto importante. Ma non risolverà il problema umano. E penso che ora l’unico modo veramente efficace per farlo sia a livello globale. E per questo abbiamo bisogno di una cooperazione globale sulla regolamentazione dell’IA, regolando lo sviluppo dell’IA e della biotecnologia, e stiamo, ovviamente, andando nella direzione opposta della cooperazione globale.

TH: Sono d’accordo sul fatto che c’è questa nozione di teoria dei giochi. Certo, Facebook e Google potrebbero farlo, ma non importa perché il gatto è fuori dal sacco, e i governi lo faranno, e altre aziende tecnologiche lo faranno, e l’infrastruttura tecnologica della Russia lo farà. Quindi come si fa a impedire che accada?

Non per riportarlo indietro – non per equiparare la schiavitù in modo simile, ma quando l’Impero britannico decise di abolire la schiavitù e sottrarre la loro dipendenza da questo per la loro economia, in realtà erano preoccupati che se lo facciamo noi, l’economia della Francia sarà ancora alimentata dalla schiavitù e loro saliranno molto più in alto di noi.

Quindi, dal punto di vista della concorrenza, non possiamo farlo, ma il modo in cui ci sono arrivati è stato quello di trasformarlo in una questione di diritti umani globali universali.

Questo ha richiesto più tempo, ma penso che sia come dice Yuval, sono d’accordo che si tratti di una conversazione globale sulla natura umana e la libertà umana. Se c’è una cosa del genere, ma almeno i tipi di libertà umana che vogliamo preservare e che penso sia qualcosa che è effettivamente nell’interesse di tutti e non è necessariamente uguale la capacità di raggiungere questo obiettivo perché i governi sono molto potenti. Ma ci muoveremo in quella direzione avendo una conversazione globale su questo.

NT: Quindi finiamo questo dando qualche consiglio a qualcuno che sta guardando questo video. Hanno appena guardato un video di Alex Jones e l’algoritmo di YouTube è cambiato e lo ha mandato qui, e in qualche modo sono arrivati a questo punto.

Hanno 18 anni, vogliono dedicare la loro vita a fare in modo che la dinamica tra le macchine e gli esseri umani non diventi di sfruttamento e diventi una in cui continuiamo a vivere le nostre vite ricche e soddisfatte. Cosa dovrebbero fare o che consiglio darebbe loro?

YNH: Direi che, conosci molto meglio te stesso e fatti meno illusioni possibili su te stesso. Se un desiderio si affaccia nella tua mente, non dire semplicemente “bene, questo è il mio libero arbitrio. Ho scelto questo quindi è buono, dovrei farlo. Esplorate molto più a fondo. In secondo luogo, come ho detto, unitevi a un’organizzazione. C’è molto poco che puoi fare da solo come individuo. Questi sono i due consigli più importanti che potrei dare ad un individuo che ci sta guardando ora.

TH: E penso che il tuo suggerimento precedente di capire che la filosofia della semplice scelta umana razionale è – dobbiamo passare da un modello del 18° secolo di come lavorano gli esseri umani ad un modello del 21° secolo di come lavorano gli esseri umani.

Il nostro lavoro è che stiamo cercando di coordinare una specie di movimento globale per risolvere alcuni di questi problemi intorno alla tecnologia umana. E penso che, come dice Yuval, non si possa fare da soli.

Non è come, lasciatemi trasformare il mio telefono in scala di grigi o lasciatemi presentare una petizione al mio membro del Congresso da solo. Questo è un movimento globale. La buona notizia è che nessuno vuole la fine distopica delle cose di cui stiamo parlando. Non è che qualcuno dice no, no. Sono davvero entusiasta di questa distopia, voglio solo continuare a fare quello che stiamo facendo.

Nessuno vuole questo. Quindi è davvero una questione di come possiamo unirci tutti e la cosa che vogliamo ed è da qualche parte nelle vicinanze di ciò di cui stiamo parlando. E nessuno deve prendere la bandiera, ma dobbiamo allontanarci dalla direzione in cui stiamo andando. Penso che tutti dovrebbero essere sulla stessa pagina su questo.

NT: Beh io, sai abbiamo iniziato questa conversazione in un momento in cui l’ottimista e io sono certamente ottimista che abbiamo coperto alcune delle domande più difficili che affrontano l’umanità che tu hai offerto intuizioni brillanti in loro.

Quindi grazie per aver parlato e grazie per essere qui. Grazie a voi. Tristan. Grazie a te, Yuval.

Nicholas Thompson

Fonte: wired.com

Abbiamo bisogno della vostra collaborazione ! Contiamo su di voi per un supporto economico necessario per finanziare i nostri rapporti investigativi. Se vi piace quello che facciamo, un abbonamento mensile è un riconoscimento a noi per tutto lo sforzo e l’impegno che ci mettiamo.

SOSTIENICI TRAMITE BONIFICO:

IBAN: IT19B0306967684510332613282

INTESTATO A: Marco Stella (Toba60)

SWIFT: BCITITMM

CAUSALE: DONAZIONE